Cybersicherheit auf der Überholspur: Auf dem Acronis-Partnertag

Wie viele Eindrücke und Erkenntnisse kann man vom ersten Partnertag mitnehmen? Professionell gesehen habe ich eine spannende Cyber Protection Lösung kennengelernt. Und persönlich betrachtet: wie man die ersten Schritte beim Netzwerken meistert.

Passend zum Motto „Reunite & Accelerate“ fand der diesjährige persönliche Partnertag von Acronis in der Motorworld in München statt.

Cyber Security auf der Überholspur sinngemäß, und so beschleunigten wir, zwei Kollegen und ich, gemeinsam morgens in der Haupthalle um 10 Uhr. Alle bekamen die ausgedruckte Agenda in die Hand und unser Gastgeber Acronis, der sich bereits beim Thema Backup einen großen Namen gemacht hat, zeigt in den Programmpunkten, wohin die Reise geht.

Mit Themen wie „Roadmap 2022 – wie Acronis sich dieses Jahr weiterentwickelt“, „Acronis Microsoft 365“ oder „[…] Advanced Security“ wird klar: Hier geht es um mehr als Backup-Lösungen.

Die Atmosphäre war von Beginn an entspannt. Mit der Moderatorin wärmten wir uns mit einem Jubel und Applaus auf. Wie die Fußballfans des 1. FC Augsburg, so die spontane Entscheidung, ihre Mannschaft begrüßen, sollten wir an diesem Tag in ebenso guter Stimmung die Redner empfangen. Aber von Abstiegskampf war an diesem Tag nichts zu spüren. Hier wird IT-Security auf Champions-League-Niveau gespielt.

Feature-Roadmap und Bekräftigung der Partnerschaft

Die ganze Veranstaltung stand im Rahmen der Partnerschaft und der Vorteile, die Acronis bietet. Für uns als Managed Security Service Provider ist es entscheidend, starke und verlässliche Partner zu haben. So hat jeder Partner von Acronis einen zentralen Ansprechpartner und man landet nicht in einer Hotline.

Ebenso sendeten sie die klare Botschaft, sich stark am Markt und den Kundenbedürfnissen zu orientieren und sich mithilfe ihrer Partner und Mitarbeiter fortzuentwickeln. Im Fokus stand das Motto: „Veränderung ist gut“. Acronis stellt das „WIR“ in den Vordergrund anstatt das „ICH“, was man an der Investition in Partner und Mitarbeiter sieht. Das hat Anerkennung verdient und es zahlt sich aus.

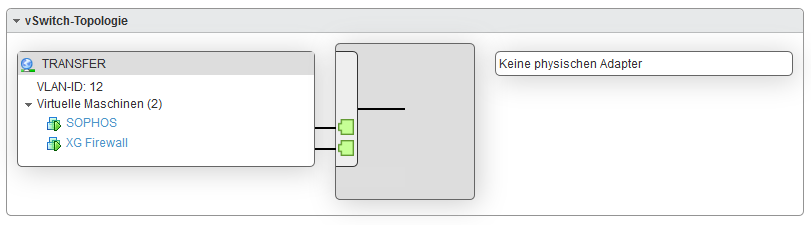

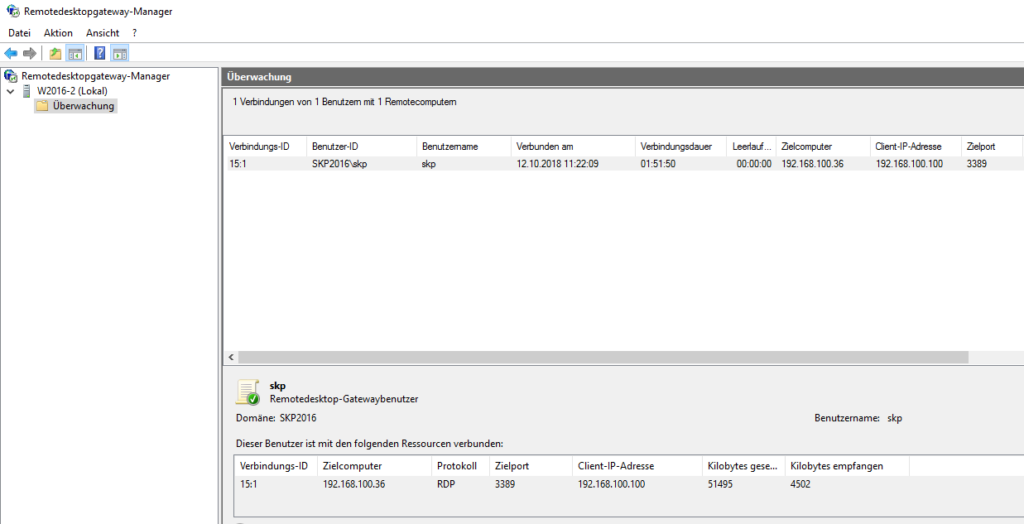

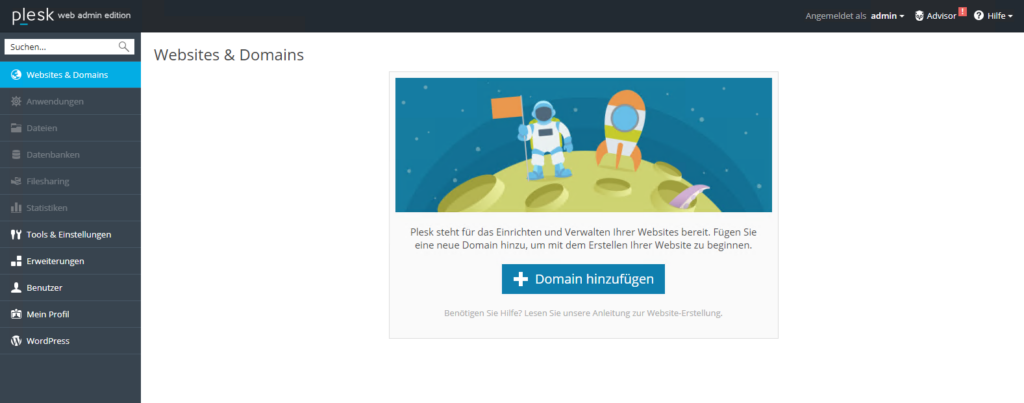

Dank der vielen Partner, mit denen das Produkt kooperiert, ist eine Integration des Produktes in so gut wie jede Umgebung einfach und unkompliziert möglich.

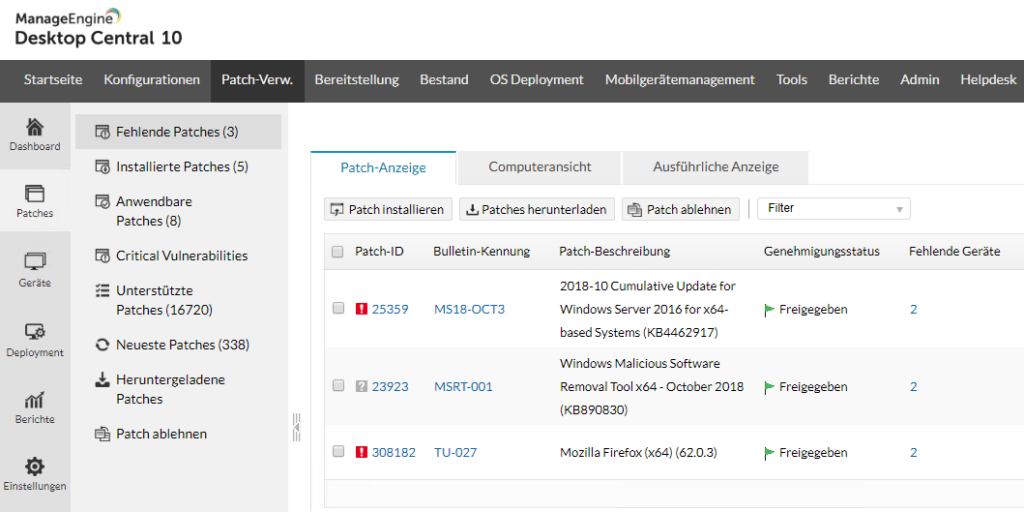

In der Roadmap 2022 wurde unter anderem folgendes vorgestellt:

- In Q1 ist eine Advanced Data Loss Prevention herausgekommen und vorerst als Beta verfügbar. Dadurch sollen Bedrohungen minimiert, Richtlinien eingehalten und die Reaktionszeit verkürzt werden

- Acronis Endpoint Detection and Response: Vorfälle sollen in wenigen Minuten untersucht werden und es wird schneller reagiert

- Papierkorb für Konten und Anwendungen: Falls etwas aus Versehen gelöscht wird, landet es im Papierkorb und kann innerhalb 30 Tagen wiederhergestellt werden

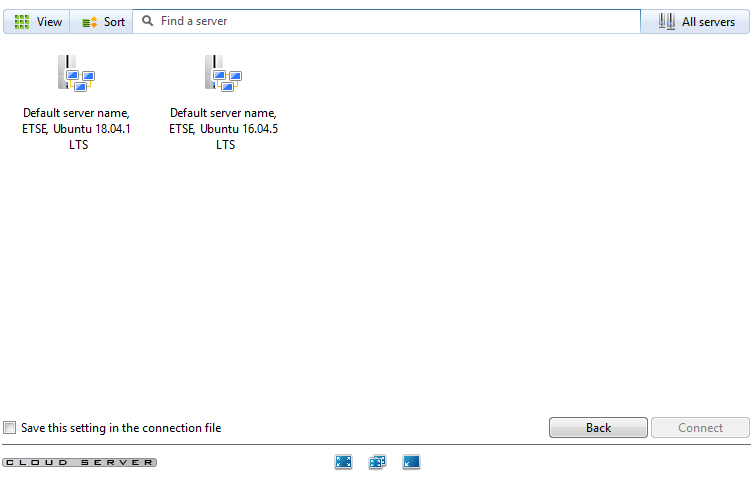

- Agentenlose Sicherung für alle Azure VMs: einfache Bereitstellung, effizientere Verwaltung und plattformübergreifend. Dabei soll alles in der Acronis Cloud gespeichert werden, was eine einfachere Handhabung und schnellere Recovery bei Bedarf als Vorteil hat.

- Wiederherstellung soll komfortabler werden – mit einem Klick und ohne große IT-Kenntnisse soll jeder benötigte Daten wiederherstellen können

- Automatisierte Testfailover mit einem KI-gestützten Screenshot-Überprüfungs-Mechanismus

- Acronis #CyberFit-Score Konfigurationsbewertung: Bewertung der Sicherheitslage der Workloads und Empfehlungen für die Konfiguration

- Verwaltung von Endpoint-Firewalls, angefangen mit der Windows Firewall

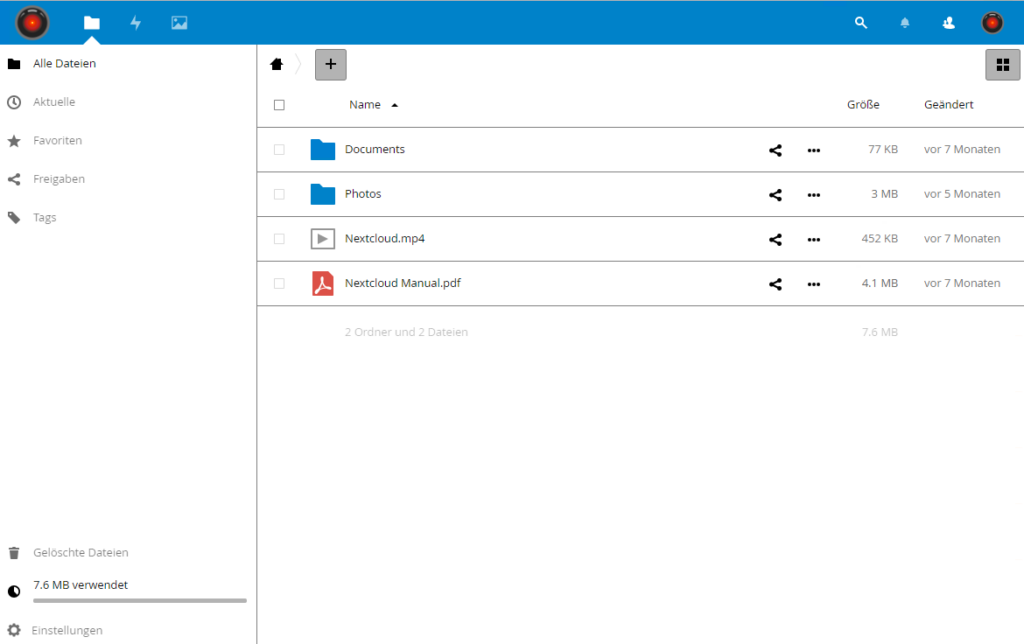

- Eine einzige Verwaltungskonsole für alle Dienste

Das hört sich alles sehr vielversprechend an. Durch die Zusammenarbeit von den verschiedenen Komponenten ist alles in einer Admin-Oberfläche zu finden und man muss nicht mehr von einem auf das andere System hüpfen. Besonders sticht für mich die Verwaltung von Endpoint Firewalls heraus, die ein gutes Zusammenspiel der einzelnen Unternehmen benötigt.

Vorträge über KI, Ransomware und Cyberversicherungen

Hinzu kamen weitere Vorträge zu aktuellen Themen. Besonders beeindruckend finde ich das Thema Künstliche Intelligenz (KI). Hier erwartet uns eine völlig neue, interessante und doch auch erschreckende Welt, die wir derzeit gar nicht richtig einschätzen können. Ich finde alles, was mit KI zu tun hat, sehr aufregend.

In einer Live Ransomware Attacke wurde gezeigt, warum Acronis wichtig und sinnvoll ist. Acronis hat eine Automatisierung, die durch einen Anti-Malware-Schutz automatisch z. B. Verschlüsselungen erkennt und diese stoppt und aus dem Backup direkt die verschlüsselten Dateien wiederherstellt. Acronis prüft Backups, bevor sie gemacht werden, und prüft sie auch nochmals auf Ransomware, bevor die wieder eingespielt werden.

Die Vorträge der Partnersponsoren waren ebenfalls sehr interessant. Unter anderem wurde von einer Cyberversicherung verständlich und kompetent erklärt, wofür und warum überhaupt auch eine Cyberversicherung hilfreich ist. Sie bietet finanziellen Schutz gegen IT- und Cyberrisiken aller Art. Dazu gehören auch eventuelle wirtschaftliche Folgeschäden.

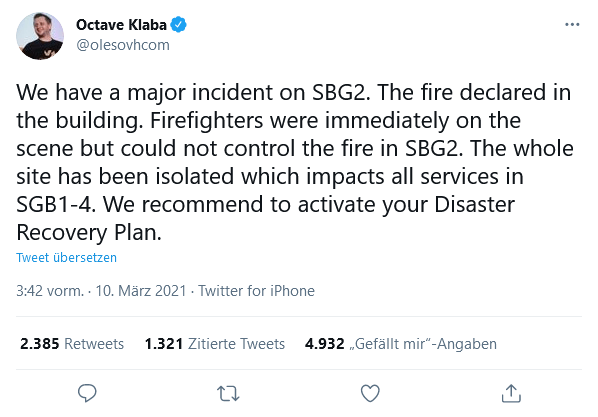

Es entbindet aber nicht vom Einsatz von Cyber-Checkups, Schwachstellen-Scans und Mitarbeiterschulungen, die Risiken von vornherein minimieren. Zu einem umfassenden Schutz gehören auch Notfall- und Krisenpläne, durch die man für den Ernstfall optimal vorbereitet ist und handlungsfähig bleibt.

Zum Abschluss des Events wurde ebenfalls in der Motorworld ein Carrera-Turnier veranstaltet, wobei im unteren Bereich zwei Bahnen mit jeweils vier Rennwagen aufgebaut wurden. Nach einer kurzen Anleitung und Einlernphase wurden schon die ersten Rennen ausgetragen. Vorsicht: Vollgas geht hier nicht, sonst kommt man schnell aus der Bahn!

Ausklang und die ersten Networking-Schritte

Anschließend hatten wir die Wahl: Zurück zum Hotel oder direkt zur Abendveranstaltung. Keine Frage, für uns ging es selbstverständlich zum Netzwerken und besseren persönlichen Kennenlernen zum Abendevent.

Ich selbst gehörte zu den Jüngeren in der Runde und wurde von den anderen hervorragend aufgenommen. Wir haben alle ein Gespräch auf Augenhöhe geführt. Für mich war alles neu, interessant und perfekt zum Lernen.

Erleichtert wurde das Netzwerken durch die besondere Sitzordnung. Die Tische waren gemischt, Partner und Acronis-Mitarbeitern bunt verteilt. Somit entstand direkt eine entspannte Atmosphäre zum Austausch. Während der Pause zwischen den Gängen habe ich mich sehr gerne mit anderen Teilnehmern und auch den Acronis Mitarbeitern sowohl über deren Unternehmen als auch das Produkt Acronis und seine Vielfältigkeit unterhalten.

Mein Fazit: Gelungener Sprung ins kalte Wasser

Abschließend kann ich nur ein Riesenlob an die Gastgeber und ein herzliches Danke an Acronis mitgeben. Es war überwältigend, informativ und eine großartige Erfahrung. Da ich davor noch nie auf einem Partner Event war, war natürlich alles neu und vieles hat mich positiv überrascht. Ich hatte im Vorfeld zum Beispiel angenommen, dass die Informationen mehr in Richtung Verkauf als technisch gehen würden, wobei sich am Ende das Gegenteil erwies.

Ebenfalls war ich etwas nervös vor dem „Networken“, also das Hingehen und Ansprechen oder angesprochen zu werden. „Worüber kann und darf ich reden?“, habe ich mich anfangs gefragt. Aber meine Nervosität war unbegründet, es lief viel besser als erwartet und mit jedem Wort habe ich mich wohler und sicherer gefühlt.

Ich habe nun einen besseren und tieferen Einblick in das Acronis-Produkt bekommen sowie die Erfahrung gemacht, sich an einem großen Event persönlich vor Ort mit anderen Menschen zu vernetzen. Vieles war neu für mich, und was ich auf jeden Fall mitgenommen habe, ist diese kurz und knackige Botschaft:

Kein Backup – kein Mitleid!

Zum Autor

Alina Radulovic

Service Manager Managed Services